网站:https://modelcontextprotocol.io/introduction

smithery.ai

文章作者: apostle

版权声明: 本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 apostle的数字花园!

相关推荐

2024-11-18

关于大模型变革影响的探讨

背景今天在群里突然看到有朋友分享关于大模型一些发展观点,仅为探讨,观点如下:咋一看,我觉得好像是对的,但是仔细想一想,又觉得哪里不太对,一时间没有琢磨明白,所以准备展开说说,作为记录。 1. 大模型是否被高估?是否所有应用需要重做?是否所有应用都需要重做,这个仁者见仁,智者见智。应用是否被需要,其实主要还是看消费者是否能买单,会接受,不然所有的应用本身都是在自嗨。但是无可否认的是,通过大模型切入一个已有的应用,确实是一个很好的切入点。已有的应用意味着啥?意味着有稳定的受众,稳定的需求!大模型的特点是啥,效率!他提升了生产端的效率,重构了生产端的组织结构,在某些领域,原来50个人来完成的事情,现在有可能5个人就可以完成。生产者组织的提升,效率的升级,意味着可以以更低的价格,更个性化的服务去替代原有的场景有应用。而且另外大模型还带来了一个产业的灰色地带,就是版权模糊。你看到好看的文案,心仪的设计,将文案放入GPT,将设计转化为文字再重新变成图片,你就可以放心的用。天呐,想想看,这是一件多么兴奋的事情。哪些以前封存在版权、无法使用的设计、方案,就这么赤裸裸的放在你的面前,你只需要用大模型,转换一下,你就可以拥有!这在某些场景,完全是重构,是对组织场景的重构,对版权专利的重构!想想就那么让人兴奋,如果就这方面来说,我觉得大模型完全没有被高估!(当然大模型带来的幻觉问题也是现实问题,这点也是需要展开说说) 2....

2024-11-20

大模型对于学习行为模式的影响

最近使用大模型的工具比较多,通过大模型进行代码开发,文案生成,图像生成等,确实感觉到学习模式的改变。以最常用的代码编程来说,我已经很久没有写代码了,而且也只会C语言的代码,但是通过cursor,我可以完成object C、java、js等多个语言的应用程序开发。究其原因,是因为掌握一门语言开发,其实最本质的核心还是思想,是让程序怎么做。然后通过学习这门语言,了解他的语法、环境、命令以及这门语言某些新的特性。在新接触一门语言的时候,其实最花时间的是其语法和环境。打个比方,你想写一个关于抓取京东商品的爬虫,你定义好了输入输出,但是写的过程中,大量的时间都在查有什么函数可以做爬虫,是否语法上有空格,某个词组写错了等等一系列的繁杂问题,等所以这些都了解了,顺了,你才可以把你的思想通过语言进行呈现。但有了大模型就不同了,可以告诉大模型来搭建对应的环境,使用注释来告诉大模型你需要什么样的效果,大模型快速生成了代码,你可以根据代码进行解读修改,如果说以前的学习是一个“先知后行”的方式,那么现在大模型的方式,可以称得上“致知于行,知行合一”。学习其实都是一个收集、整理、理解、吸收的过程,大模型可以通过其海量的数据,把收集、整理的时间大幅度缩短,将想要的信息快速呈现在眼前。理解和吸收最主要还是个人的事情,不同的个体对于世界的理解是不太一样的,不过其实也可以根据不同的人和历史信息进行微调,把知识按照每个人不同的理解方式喂到嘴边,这有可能也是大模型后续的一个发展方向。大模型这一波对于大多数人的学习行为模式的改变是毋庸置疑的,在这一波学习行为模式改变中,我觉得对于未来我们应该着重培养如下几点: 1....

2024-11-25

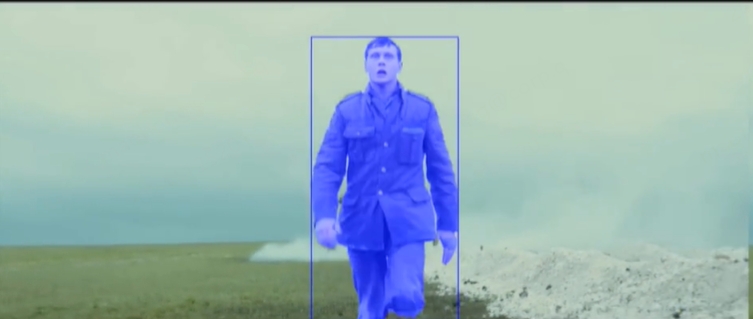

SAMURAI增强版分割模型

1. 背景<<<<<<< Updated upstream最近在11月18日看到arxiv上发表了SAMURAI,这是一个针对万物切割SAM(segment anything model)的开源版本,解决传统目标跟踪算法在复杂场景中的挑战,比如快速移动、移动遮挡等环境,相比于SAM,SAMURAI具备更好的性能,在物体部分遮挡的时候依旧有很好的性能。关于官网的产品介绍如下:最近在11月18日看到arxiv上发表了SAMURAI,是华盛顿大学做的一个针对万物切割SAM(segment anything model)的开源项目,目的是为了解决传统目标跟踪算法在复杂场景比如快速移动、移动遮挡等环境中遇到的跟踪丢失、目标不全等问题。其实在去年华盛顿大学已经开源过一个版本SAM,不过相比于SAM,SAMURAI具备更好的性能,在物体部分遮挡的时候依旧有很好的性能。关于官网的产品介绍如下: Stashed changes 123网站:https://yangchris11.github.io/samurai论文:https://arxiv.org/abs/2411.11922github:https://github.com/yangchris11/samurai 视频案例如下: 您的浏览器不支持视频播放。 1917 (2019), directed by Sam Mendes. 您的浏览器不支持视频播放。 1917 (2019), directed by Sam Mendes. 可以看到官网的案例,整体视频追踪的效果看起来还是不错的,我们整体安装试试。 # 2. 安装 首先查看自己的python、torch和torchvision的版本,要求:`python>=3.10`,...

2024-11-19

【1】COGVIDEO生成视频

1. 背景cogvideoX是清华和清影同源的开源视频生成大模型,详情可以查看:CogvideoX其中模型差异如下: ![[09 大模型专区/ob_photo/Pasted image 20241102155335.png]] 2. 搭建2.1 搭建comfy-ui下载和使用comfy-ui,配置可以查看:FLUX安装与使用 2.2 下载ComfyUI-CogVideoXWrapper进入comfyUI,下载CogVideoXWrapper,这是一个cogvideo的中转器 123cd ComfyUI/custom_nodesgit clone https://github.com/kijai/ComfyUI-CogVideoXWrapper.gitgit clone https://github.com/MinusZoneAI/ComfyUI-CogVideoX-MZ 2.3 启动comfyui启动即可,–listen是监听IP,一般是你自己服务器的IP,如果没有设置listen,则是默认的locatehost 1python3 main.py --listen 10.229.41.60 然后访问对应的8188端口即可。 1http://10.229.41.60:8188 ⚠️ 注意: ==操作前请备份重要文件。注意直接启动可能会报错,因为他运行会安装Python的依赖,其实就是需要安装ComfyUI-CogVideoXWrapper的依赖,这个使用需要仔细看原因,或者手动安装依赖.== ==一定要安装python 3.12以上的版本,不然会跑不起来==1234567# 安装ComfyUI-CogVideoXWrapper的依赖cd custom_nodes/ComfyUI-CogVideoXWrapperpip install -r requirements.txt# 安装comfyui的依赖cd ComfyUIpip install -r...

2024-11-17

【1】FLUX安装与使用

1.背景最近,由前Stability AI员工创立的黑森林实验室推出了开源图像生成模型Flux.1,受到了广泛关注,迅速在网络上走红。Flux.1是一款免费开源的模型,其性能可与Midjourney V6相媲美。用户可以通过Comfyui来调用Flux.1。本文将主要介绍如何安装和调试Flux模型。详情可见网站页面:https://blackforestlabs.ai/试用网页:http://hugginface.co/black-forest-labsFlux 模型总共有3个,分别是:Flux Pro、Flux Dev、Flux Schnell,下面是其性能的对照图 [pro] 是最顶级的模型,但是只能通过 API 调用; [dev] 是由[pro]提炼,开源但非商用,质量和效果与[pro]类似; [schnell] 是经过蒸馏的 4 步模型,速度比 [dev] 快 10 倍,Apache 2 开源许可。 2. 安装目前 ComfyUI 已支持此模型,更新到最新版即可使用。 2.1 下载最新版 ComfyUI1git clone https://github.com/comfyanonymous/ComfyUI.git 2.2 设置中文语言和插件库123456# 下载到custom_nodescd ComfyUI/custom_nodes# 安装中文语言git clone https://github.com/AIGODLIKE/AIGODLIKE-ComfyUI-Translation.git# 安装插件库git clone https://github.com/ltdrdata/ComfyUI-Manager.git 2.3 下载flux模型FLUX 模型有四个可选,FLUX.1 [dev] 、FLUX.1 [dev] fp8、FLUX.1 [schnell]、FLUX.1 [schnell] fp8⚠️...

2024-11-28

【2】FLUX的4个控制工具

1. 背景在2024年的12月21日,Flux重磅发布了Flux.1的工具,这四套模型旨在为基本文本到图像模型FLUX.1 添加控制和可控性,从而能够修改和重新创建真实和生成的图像。在发布时,Flux.1工具包含了四个不同的功能。 FLUX.1 fill重绘模型: 最先进的修复和图像处理模型,在给定文本描述和二进制掩码的情况下,支持编辑和扩展真实和生成的图像。 FLUX.1 depth深度控制模型: 经过训练的模型,可根据从输入图像和文本提示中提取的深度图来启用结构引导。 FLUX.1 canny线稿控制模型: 经过训练的模型,可以根据从输入图像和文本提示中提取的边缘信息来启用结构引导。 FLUX.1 redux风格迁移模型: 允许混合和重新创建输入图像和文本提示的适配器。1网址:https://blackforestlabs.ai/flux-1-tools/ 1.1 FLUX.1 fill重绘模型最先进的修复和图像处理模型,在给定文本描述和二进制掩码的情况下,支持编辑和扩展真实和生成的图像。比如可以支持掩码修复。支持图像扩展: 1.2 FLUX.1 depth 和canny模型经过训练的模型,可以根据从输入图像和文本提示中提取的边缘信息和深度信息结构,重新绘制。 1.4 FLUX.1 redux模型适配器可以允许输入图像和文本重新进行绘制,给定一个输入图像,FLUX.1 Redux 可以再现图像,但有轻微的变化,从而允许优化给定的图像。 2. 实际安装进入官网的comfyui链接网址:https://comfyanonymous.github.io/ComfyUI_examples/flux下载fill model: 12345cd ComfyUI/models/diffusion_models# huggingfacewget https://huggingface.co/black-forest-labs/FLUX.1-Fill-dev/resolve/main/flux1-fill-dev.safetensors?download=true#...

评论